图1 “长远未来模型”的基础是宝马X3车身

具有数百万个元素和数百万个自由度(DOF)的高度详细的网格已变得很常见,并且模型规模仍在不断扩大。随着数值方法和软件工程技术的改进,各程序的工作效率不断提高,计算能力也不断增强,模型创建及网格划分软件的快速发展也使模型的生成变得迅速而方便。若干年前,气缸体的网格划分也许需耗费数月,而如今却仅需几个小时。

一些公司在运用和推动模拟技术方面达到了很高水平,德国轿车制造商宝马公司便是其中之一。为帮助宝马公司和其他制造商缩短开发周期,减少原型数量和测试次数,整车模型在日益复杂的模拟模型的基础上得到了优化,比如进行了声学和舒适度的刚度评估、提高了乘客安全性、考虑了空气动力学因素等。在数值方面,则通过执行隐式线性分析和显式瞬态分析来完成这一测试。

长远未来模型

FEM模型的规模和细节在相应不断增加,这一趋势在汽车行业尤其明显。正因为如此,德国轿车制造商宝马公司有以下疑问:“FEM程序还能应对这种增长多久?”2007年年初,有关人员对宝马公司的电脑辅助工程流程链进行了评审,目的是查明由于模拟模型的规模不断扩大而在今后可能出现的瓶颈。在“长远未来模型”这一座右铭下,某一基准的目标就是给硬件和软件施压,使它们接近该基准在今后十年将面临的极限。MSC.Software公司和IBM公司已成功完成了这一测试。

图2 平均模型规模观测值,包括2020年预测值

命名为“长远未来模型”的功能设计及安装调试组为某系统基准开发了目前已知最大的FEM模型。小组成员Daniel Heiserer博士曾表示:“对于我们而言,在标准硬件设备和软件上运行该基准非常重要。用目前的基础设施来解决该基准模型,其目标并不是缩短计算时间,而是查明目前各种资源的理论极限和瓶颈。由于预处理和后期处理被单独研究,因此我们全身心投入于纯计算。”

基准的目标是为某标准分析(对两个载荷案例进行线性静态分析)确定FEM分析的基本步骤可被执行到何种程度,并能在多长时间内完成:

1. 读取输入数据,将其分类并列表,执行一致性检查;

2. 对元素刚度矩阵进行计算,并编制全局刚度矩阵;

3. 对位移和刚度数据进行计算;

4. 输出结果。

MSC.Software公司与IBM公司合作,得以在数月内解决该问题。

历史及现状

大多数老牌FEM程序起源于计算性能尚未达到最佳状态之时。1957年,Ray W.Clough先生和他的学生们利用一台内存仅为16KB(16位)的IBM 701计算机研制出了日后所说的有限元方法(FEM)。当方程数量超过40个时,问题需要核外求解逻辑,这意味着需要使用第二存储介质。10年后,当Nastran问世时,相关要求依然相似。作为客户的NASA需要一个能对具有至少2个自由度的问题进行静态和动态分析的程序。

今天,这一切似乎已成历史。随着CPU速度、效率以及内存容量的提升,无需“核外”运算即可计算各种需要强大计算能力的基本运算,比如有限元矩阵的生成和编制。即便当代的MD Nastran也反映了早期的软件设计考虑事项,例如节省电脑内存,以及借助“核外”或“溢出”算法来高效使用磁盘I / O子系统。就本项目而言,这些特性对于全局刚度与质量矩阵的生成极有帮助。

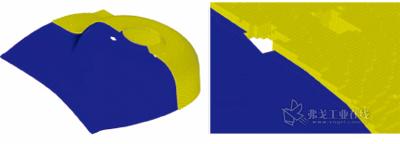

图3 宝马X3车型的冲击塔的外壳模型(蓝色),MODAW体积表示(黄色)

基础模型

在宝马公司,模型生成的基础是宝马X3的白车身,即不带任何装饰部件的金属板车身基本设计。鉴于该车型的尺寸,工程师们以经验值的外推作为方向,该项工作为2020年预测了大约8亿个自由度。

网格划分程序由Heiserer博士开发,并运用了原始网格划分技术(RAT),它可对复杂几何形状实现极快的HE-XA网格划分,即使在不连贯或有错误的CAD几何形状基础上也是如此。RAT建模的缺点是模型极大,并且只能对基础刚度属性做有意义的模拟。

基准最终模型的最大边长为1mm,包含1.51亿个格点、将近9 500万个HEXA元素和9.11亿个全局自由度。如果去除旋转自由度,则问题规模可达4.55亿个待解方程。

为确保各项面向实践的条件,并把成本限制在可管理的规模内,应借助商品化程序和单处理器电脑来运行该测试。IBM公司设在美国纽约州波基普西市的美国基准中心的电脑就适合于FEM征兆式I/O和内存要求。使用的电脑系统是IBM p5-595 2.3GHz POWER5+,配备512GB内存和6TB临时文件系统,后者由48个硬盘组成,每块硬盘容量为146GB。为实现可用内存的最优利用,使用了ILP-64版MD Nastran。为了对全局(编制后的)刚度矩阵进行因子分解,采用了稀疏直接多波前算法,它具备嵌套剖分重排序特性。

全局刚度矩阵是大约9 500万个元素刚度矩阵的组合。得到的因子矩阵包含571.011个待解项(超过4TB数据),最大波前大小估计值大于100 000。求解需要将近1个CPU年。由于没有这么多时间,因此决定采用包含PCGLSS迭代求解器的迭代解,它需要的内存和磁盘空间明显更少,并且对于包含三维有限元的模型而言特别有效。提交的分析工作需要50GB内存,并且模块化I/O (MIO)额外需要10GB内存。

MIO是IBM公司开发的一种智能I/O缓存。在MD Nastran中常见的I/O密集型运算期间,MIO使用较少的内存来以异步方式预取数据。

为了处理如此大量的数据,必须进行若干修改以及系统参数和输入数据的设定,例如格点ID内部最大号码的运行时参数被增加至1.60亿(标准值为1.00亿),并且由于所用内存的大小和种类的缘故,修改了PCGLSS求解器的参数。

图4 本项目所用的电脑系统IBM p5-595 2.3GHz POWER5+

在输入数据时,取消了格点权重发生器输出请求以及质量矩阵的生成,节省的时间和I/O量分别为22min/226GB和1.4h/450GB。由于电脑资源有限,未计算第二个载荷案例。

分析结果

完成串行方式的分析计算用了1337min。使用的CPU秒数为76 254;CPU利用率为95%。若对第二个载荷案例做分析,则总计算时间会增加15h(53 786s),达到37h。

总共需要2.27TB临时文件磁盘空间。分析工作耗费了7.8TB磁盘I/O。用于后期处理的二进制输出文件大小为99.9GB,包含未变形的几何形状以及用于某个载荷案例的输出(位移和应力)。PCGLSS求解器收检时的公差为9.9803e-05(149次迭代),并且额外需要大约230GB内存。使用的内存总量约为300GB(60GB用于MD Nastran,10GB用于MIO缓存,230GB用于PCGLSS求解器)。

尽管内存、磁盘、I/O要求极高,但计算是在标准硬件平台上,用标准软件执行的。由于MD Nastran分析软件具有“核外”能力,因此它适合于极大问题的计算。除了软件的高效率之外,IBM POWER5-架构(具有大内存以及统一而高效率的存取速度)使我们能在充分的时段内执行计算,因此它也是至关重要的。