从自动驾驶看汽车数字化转型

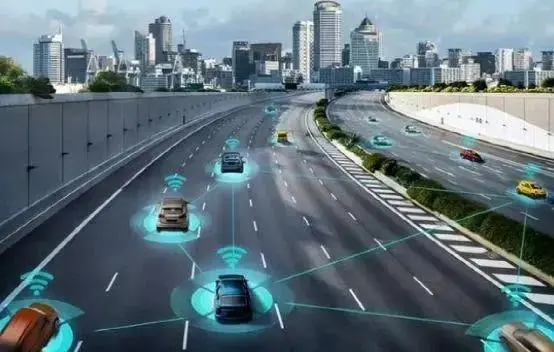

2023年10月,全国首条满足车路协同式自动驾驶等级的全息感知智慧高速公路测试路段在苏州投入使用。

2023年12月,宝马集团搭载L3级别自动驾驶功能的车辆在上海市正式获得高快速路自动驾驶测试牌照。

2023年12月16日,《北京市智能网联汽车政策先行区有条件自动驾驶功能汽车道路测试管理细则(试行)》出台。

2023年12月18日,智己汽车宣布,在上海市正式获得高快速路自动驾驶测试牌照。

2023年12月22日,极狐宣布将正式在北京指定道路开展有条件的自动驾驶系统实际道路测试。

2023年12月27日,据比亚迪官方消息,2023年7月21日,比亚迪在深圳拿到全国第一张有条件自动驾驶(L3 级)测试牌照。

2023年12月29日,赛力斯汽车发文宣布,2023年11月,华为和赛力斯联合打造的产品成功获得 L3 级自动驾驶测试牌照。

种种迹象表明:自动驾驶时代,开始了!!!

什么是自动驾驶?

L1解放双脚

有限地干预车辆行驶系统,有少量的控制权,只有单一功能且驾驶员可随时接管车辆。功能包括自适应巡航和紧急制动功能等。

L2解放双手

能够完成某些驾驶任务,但驾驶员需要监测环境,完成剩余部分。假如行驶过程中出现问题,随时进行接管,比如:低速自动跟车、高速路快速行车和驾驶员在车内的自动泊车等。在这个层级,自动系统的错误感知和判断需要有驾驶员随时纠正。

L3解放双眼系统可以接管驾驶,驾驶员可以“开个小差”。当系统检测到驾驶环境不妥时驾驶员就需要重新介入了,所以在该层级下驾驶者仍无法进行睡觉或者深度的休息人类驾驶员需要保持注意力以备不时之需。

L4解放大脑在一定条件下,系统完全接管汽车。驾驶员此时可以放任自由且无需担忧重新接管车辆。系统可以完成车辆驾驶任务并实时监控驾驶环境作出反应。

L5解放驾驶员完全不需要驾驶员的自动驾驶终极形态——在这个等级,驾驶者不需要执行任何操作,只需要告诉车辆目的地,动动嘴,就可以出发。Amazing!脑补一下那些天马行空的科技感画面吧!

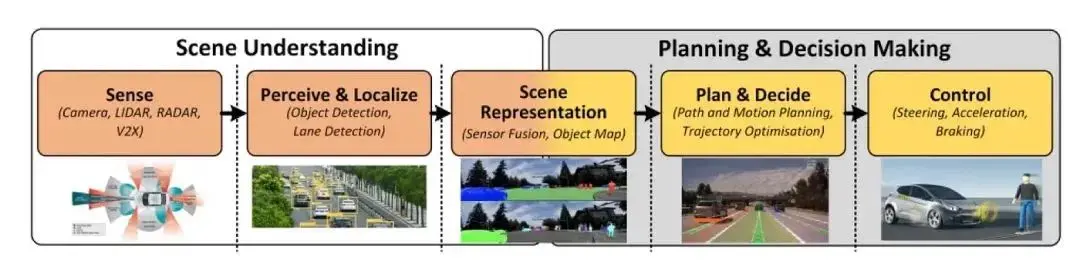

如何实现自动驾驶

要实现自动驾驶,需要做到这四点:地图、感知、决策、控制 。

地图:北斗卫星导航系统大家都知道,这是自动驾驶不可或缺的技术,另外有通信技术V2X(Vehicle To Everything),保证了车辆与外界网络信息的高效交换。另外一项技术,叫做惯性测量单元(IMU), 可以弥补GPS的误差,并且根据加速度来判断自身的运动方向。

感知:被定义为环境信息和车内信息的采集与处理,涉及道路边界检测、车辆检测、行人检测等多项技术,可认为是一种先进的传感器技术,所采用的传感器包括激光雷达、摄像头、毫米波雷达、超声波雷达、速度和加速度传感器等。由于单一传感器存在感知的局限性,并不能满足各种工况下的精确感知,自动驾驶汽车要实现在各种环境下平稳运行,需要运用多传感器融合技术,该技术也是感知层的关键技术。

决策:可以理解为依据感知信息来进行决策判断,确定适当工作模型,制定相应控制策略,替代人类驾驶员做出驾驶决策。这部分的功能类似于给自动驾驶汽车下达相应的任务。例如在车道保持、车道偏离预警、车距保持、障碍物警告等系统中,需要预测本车及相遇的其他车辆、车道、行人等在未来一段时间内的状态。先进的决策理论包括模糊推理、强化学习、神经网络和贝叶斯网络技术等。由于人类驾驶过程中所面临的路况与场景多种多样,且不同人对不同情况所做出的驾驶策略应对也有所不同,因此类人的驾驶决策算法的优化需要非常完善高效的人工智能模型以及大量的有效数据。这些数据需要尽可能地覆盖到各种罕见的路况,而这也是驾驶决策发展的最大瓶颈所在。

控制:是指系统在做出决策后,按照决策结果对车辆进行控制。车辆的各个操控系统都需要能够通过总线与决策系统相连接,并能够按照决策系统发出的总线指令精确地控制加速程度、制动程度、转向幅度、灯光控制等驾驶动作,以实现车辆的自主驾驶。

人工智能

智能网联

利用多目视觉、激光雷达、毫米波雷达等传感器件及识别算法,可以实现对实际道路环境中多曲面物体的准确识别;利用基于先进传感器的地图采集技术可以提取道路的详细标注(标志、标线、信号灯等)和高精度位置(经度、纬度、高度等)等信息,从而实现自动驾驶汽车对道路平面特征的提取,同时基于深度学习可实现对道路可行驶、不可行驶区域的认知识别。

结合通讯技术的发展,运用车与车、车与路、车与人、车与云之间的实时通讯技术,可为人工智能技术在自动驾驶技术应用过程中的数据、计算与算法等三大要素提供进一步支持,还可面向多车型、多场景智能驾驶需求,提供解决群体智能驾驶系统协同驾驶所面临的问题。

大模型与自动驾驶

关注Talk2Drive机器人实验

如果基于大型语言模型(LLM)能实现理解和执行自动驾驶汽车的口头指令,将不再局限于简单的“你好XX,打开天窗、关闭空调”之类的指令,而是涉及到真正操纵汽车在道路上行驶的复杂指令,那将是一种何等神奇的体验。

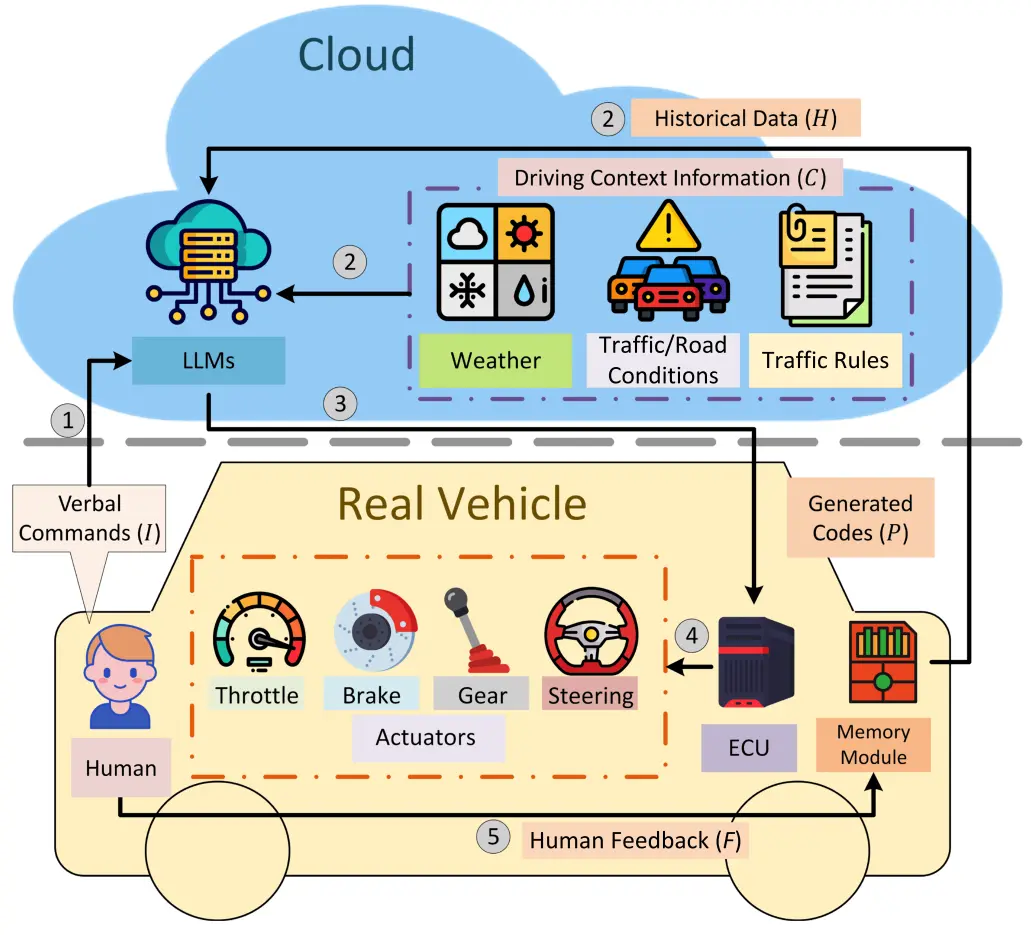

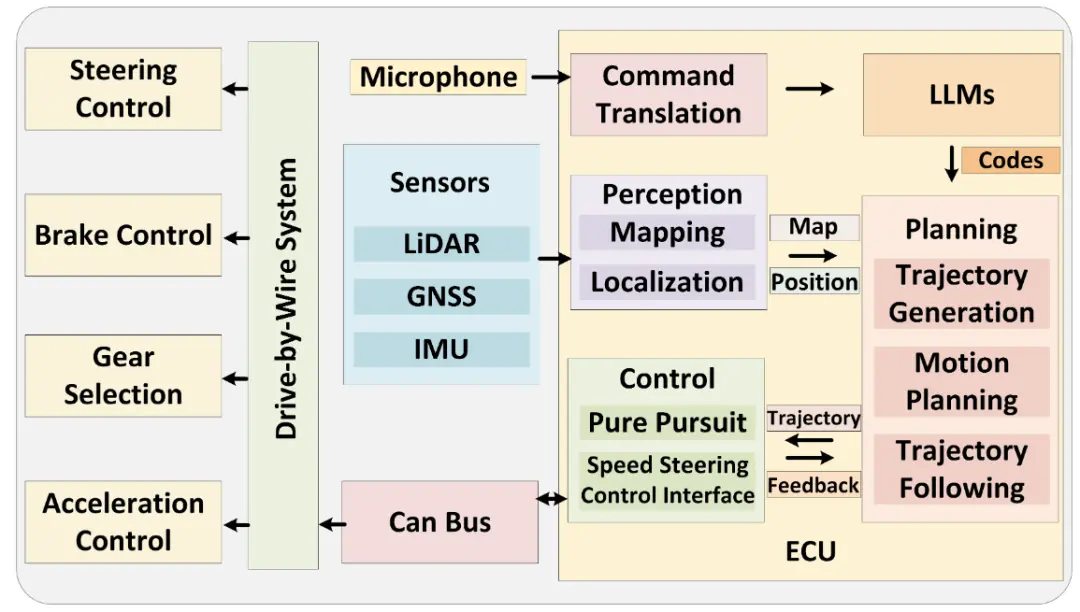

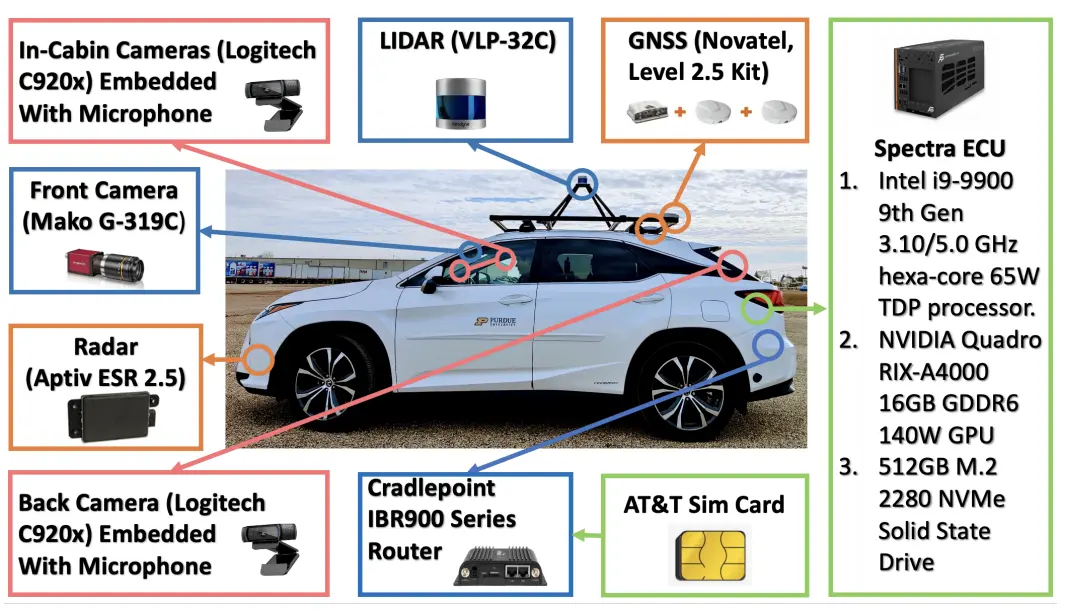

论文Large Language Models for Autonomous Driving: Real-World Experiments介绍了自动驾驶框架Talk2Drive,该框架利用 LLM 来解释和回复人类的各种指令,尤其是那些抽象或具有情感色彩的指令,同时利用历史互动数据来实现个性化的驾驶体验。与传统系统需要精确输入的情况不同,Talk2Drive 框架允许与车辆进行更自然和直观的交流。

与传统系统相比,LLM 在自动驾驶方面具有以下优势:

- 对抽象表达的理解:传统系统在理解人类的抽象指令方面存在困难,而 LLM 能够理解和适应各种人类情绪和上下文线索。

- 个性化驾驶体验:LLM 能够根据人类的历史偏好和命令提供个性化的驾驶模式,从而提高驾驶体验。

- 实时性和安全性:LLM 在处理复杂人类指令时有较低的延迟,这对于实时应用和安全关键场景至关重要。

- 下一篇:丰田燃料电池研发与生产专用工厂在北京投产

- 上一篇:史上最全汽车各部件图解

-

比亚迪发布2024年ESG报告 以技术创新驱动可持续

2025-03-26 -

旭化成精细化工(南通)新工厂竣工

2025-03-18 -

新品上市|FLIR Si2x系列防爆声学成像仪,引领

2025-03-13 -

Spectrum推出可由以太网控制的超高速GHz数字化

2025-03-12

编辑推荐

最新资讯

-

全球产业链聚沪 共探双碳新路径 SNEC

2025-04-18 18:05

-

柯马签订具有约束力的协议收购 Autom

2025-04-17 13:01

-

高效协同新范式:比亚迪叉车领创智能

2025-04-17 10:04

-

埃马克德国总部迎来中国社科院工业经

2025-04-15 09:40

-

埃马克这项全新应用即将在CIMT惊艳首

2025-04-15 09:37